Autoencoders: El Ingenio Reconstruido de la Inteligencia Artificial

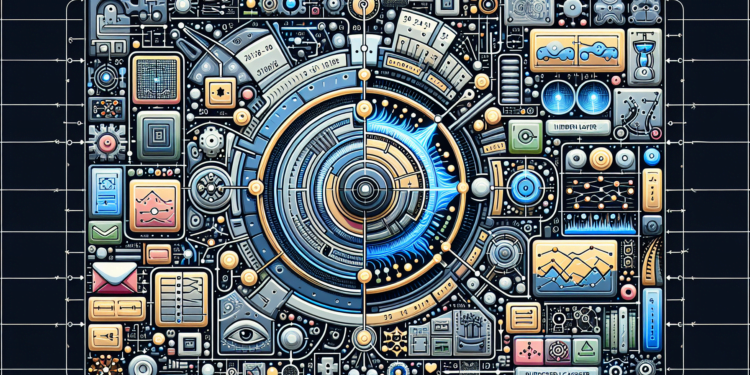

En el corazón pulsante de la inteligencia artificial (IA) contemporánea yace una arquitectura intelectual que ha revolucionado la forma en que las máquinas entienden y manipulan vastas cantidades de datos: los autoencoders. Estas arquitecturas de aprendizaje automático no supervisado exhiben una habilidad sin precedentes para aprender codificaciones eficientes de datos sin etiquetar, aprovechando una comprensión intrínseca de las estructuras subyacentes en conjuntos de datos complejos.

Fundamentos Teóricos de los Autoencoders

Arquitectura y Operación

A nivel estructural, un autoencoder convencional se compone de dos componentes: el encoder y el decoder. El encoder, una red neuronal, transforma la entrada en una representación latente o codificada, reduciendo la dimensión de los datos originales. El decoder, a su vez, reconstruye los datos a partir de esta representación latenten con el objetivo de que la salida se asemeje lo más posible a la entrada original.

Función de Pérdida

La optimización de autoencoders se efectúa minimizando una función de pérdida, tal como la Mean Squared Error (MSE) para datos continuos, que mide la disparidad entre la entrada y la salida reconstruida. Cuanto menor sea la pérdida, más fidedigna es la reconstrucción lograda por el autoencoder.

Avances Algorítmicos Recientes

Autoencoders Variacionales (VAEs)

Los VAEs inyectan una cuota de incertidumbre en el proceso de codificación al modelar la distribución de la representación latente. Introducen una capa de variables latentes sampleadas de una distribución probabilística, típicamente gaussiana, propiciando la generación de nuevas instancias de datos después del entrenamiento.

Redes Antagónicas Generativas (GANs) y Autoencoders

Las GANs, aunque distintas en su concepción, comparten objetivos similares con los autoencoders en términos de generación de datos. Se ha observado una convergencia de ambas arquitecturas en desarrollos como el Adversarial Autoencoder (AAE), que une el marco de autoencoder con la discriminación adversarial de una GAN, resultando en una mejora significativa en la calidad de las representaciones latentes y las reconstrucciones resultantes.

Aplicaciones Prácticas Emergentes

Reducción de Dimensionalidad y Visualización

En el terreno del ‘big data’, los autoencoders se han destacado por su capacidad de reducir dimensiones, facilitando la visualización de datos de alta dimensión en espacios bidimensionales o tridimensionales – una herramienta invaluable para el análisis exploratorio de datos.

Detección de Anomalías

La peculiar competencia de los autoencoders para reconstruir lo que han aprendido se presta como una técnica eficaz para identificar anomalías o datos atípicos. Al entrenarse principalmente en datos normales, estas redes tienden a reconstruir ineficientemente las anomalías, lo que permite su detección en aplicaciones como la vigilancia de fraudes o el mantenimiento predictivo de equipos industriales.

Generación y Mejora de Imágenes

Autoencoders han permitido avances en la generación y mejora de imágenes, especialmente valioso en campos como la medicina, donde las mejoras en la calidad de las imágenes pueden conducir a diagnósticos más precisos. Modelos como el DAE (Denoising Autoencoder) han mostrado eficacia en la eliminación de ruido de imágenes, aprendiendo a recuperar la señal limpia a partir de datos corrompidos.

Compresión de Datos

Dado que los autoencoders buscan representaciones más densas de los datos, resultan ser candidatos prometedores para la compresión de datos sin pérdidas, donde la eficiencia y la recuperación fiel de los datos originales son primordiales.

Evaluación Crítica: Comparativa y Prospectiva

Al comparar los autoencoders con otros métodos de aprendizaje no supervisado, como el análisis de componentes principales (PCA), estos últimos se ven limitados por su linealidad, mientras que los autoencoders, al ser redes neuronales, pueden capturar relaciones no lineales complejas entre los datos.

A futuro, podemos anticipar un desarrollo continuo en la integración de autoencoders con otros paradigmas de IA. Un ejemplo prometedor es su aplicación en el aprendizaje por refuerzo, donde la eficiente codificación de estados puede ser vital para la toma de decisiones de agentes en entornos complejos.

Estudios de caso demuestran la viabilidad y el rendimiento superior de los autoencoders en diversos escenarios, como en la optimización de sistemas de recomendación. Netflix, por ejemplo, utiliza variantes de autoencoders para mejorar la personalización de sus sugerencias de contenido, aprovechando su capacidad para discernir patrones ocultos en las preferencias de los usuarios.

Conclusión

Los autoencoders han probado ser una tecnología poderosa y versátil en el amplio espectro de la IA moderna. Con su adaptabilidad y evolución continua, desafían los confines de la compresión de datos, la generación de contenido, la detección de anomalías y más allá. Su viaje, lejos de alcanzar un ápice, sigue en expansión, con la promesa de desentrañar complejidades aún no concebidas y plantear soluciones a retos que hoy se antojan insuperables.