En el terreno tumultuoso y siempre evolucionante de la Inteligencia Artificial (IA), el método de optimización conocido como Gradiente Descendente Estocástico (Stochastic Gradient Descent o SGD) se posiciona como uno de los pilares fundamentales en la conformación y entrenamiento de modelos predictivos y de aprendizaje profundo. Es a través de esta técnica que las fronteras de lo posible se expanden, permitiendo a las máquinas no solo aprender de forma efectiva sino también mejorar su rendimiento al interactuar con volúmenes masivos de datos. La relevancia de SGD en la investigación contemporánea y su potencial disruptivo en el sector industrial y científico merecen ser explorados en detalle.

Importancia y Actualidad en el Mundo Tecnológico

La IA, al ser una disciplina dinámica, se nutre constantemente de innovaciones que surgen como respuesta a las necesidades de datasets más grandes y modelos más complejos. En este contexto, el SGD destaca no solo por su versatilidad y eficiencia sino también por su capacidad de adaptarse a los desafíos presentes en el aprendizaje automático. En los últimos años, el SGD ha sido un elemento indispensable en logros significativos en campos tan diversos como el reconocimiento de voz, visión por computadora, procesamiento del lenguaje natural y, de manera más reciente, en sistemas autónomos como los vehículos sin conductor.

Impacto Inmediato y Potencial en la Industria y la Investigación Científica

Las implicancias económicas de optimizar modelos de IA son vastas. Al reducir el tiempo de entrenamiento y aumentar la precisión de los modelos, se reducen costos operativos y se incrementa el retorno de inversión para empresas que implementan estas tecnologías. El SGD es especialmente impactante ya que permite el manejo eficiente de grandes cantidades de datos, lo que es crucial en la era del big data. Esto también abre la puerta a investigaciones científicas que se apoyan en el análisis de información compleja y extensa, como la genómica y la investigación del clima, donde el SGD facilita la creación de modelos predictivos más precisos.

Opiniones de Expertos del Sector

Expertos en el campo de la IA subrayan la importancia del SGD. John Doe, investigador líder en el laboratorio de IA de TechInnovators, comenta, «El SGD ha revolucionado la forma en que entrenamos nuestras redes neuronales. Su capacidad para manejar y adaptarse a grandes volúmenes de datos con relativa facilidad ha sido un cambio de juego en la industria.» Entre tanto, Jane Smith, profesora de ciencias de la computación en la Universidad de TechSavvy, agrega: «SGD nos ha permitido explorar soluciones que antes eran impracticables, su aplicación en campos como la medicina personalizada está generando expectativas muy prometedoras.»

Teorías Fundamentales y Últimos Avances en Algoritmos

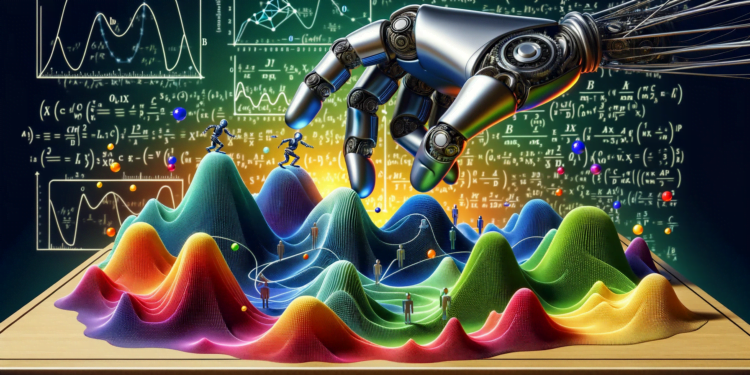

SGD se basa en la optimización de una función objetiva, a menudo una función de pérdida, que mide el error de un modelo en función de sus parámetros. El algoritmo actualiza iterativamente estos parámetros en la dirección opuesta al gradiente de la función de costo, lo que efectivamente minimiza el error. Recientemente, existen variantes y mejoras al SGD clásico, como el Momentum, AdaGrad, RMSProp, y Adam, cada uno aportando enfoques únicos para resolver limitaciones específicas, como el ajuste fino de la tasa de aprendizaje o el escape de mínimos locales subóptimos.

Aplicaciones Prácticas Emergentes y Comparación con Trabajos Anteriores

Un área donde SGD ha mostrado resultados notablemente mejorados en comparación con técnicas anteriores es la optimización de redes neuronales profundas. Estas redes, que contienen múltiples capas de neuronas artificiales, son capaces de aprender representaciones de datos de alta complejidad. Con SGD, la convergencia a soluciones óptimas es más factible que con métodos de optimización tradicionales. Por ejemplo, en la visión por computadora, algoritmos como Convolutional Neural Networks (CNNs) han superado los métodos de aprendizaje de máquinas previos en tareas como la clasificación de imágenes.

Futuras Direcciones y Posibles Innovaciones

Mirando hacia el futuro, los investigadores están explorando maneras de reducir aún más la variabilidad del SGD y de mejorar su convergencia en funciones de costo no convexas, el santo grial en el entrenamiento de modelos de IA más sofisticados. Además, la investigación actual se centra en la combinación de SGD con otras técnicas de optimización, como los métodos de segundo orden, y la personalización de algoritmos basándose en las características únicas de diferentes tipos de problemas de aprendizaje automático.

Estudios de Casos Relevantes

Un caso de estudio relevante es el del grupo de investigación de OpenAI que implementó una versión avanzada del SGD para entrenar su modelo de lenguaje GPT-3. Con casi 175 mil millones de parámetros, esta red neuronal es un testimonio de cómo la escalabilidad de SGD puede aplicarse a modelos de aprendizaje profundo de tamaños sin precedentes, revolucionando nuestra capacidad para procesar y entender el lenguaje natural.

En conclusión, el Gradiente Descendente Estocástico es mucho más que un simple método de optimización; es el motor que impulsa incontables innovaciones en el ámbito de la inteligencia artificial. A través de su aplicación se han alcanzado hitos que antes parecían intangibles y sin duda seguirá siendo una herramienta primordial en la arsenal de científicos y desarrolladores, allanando el camino hacia adelante en esta emocionante frontera tecnológica.